Уведомление о переводе ИИ

Эта документация была автоматически переведена ИИ.

Обзор

Введение

Плагин «База знаний ИИ» предоставляет ИИ-агентам возможности RAG-поиска.

Возможности RAG-поиска позволяют ИИ-агентам предоставлять более точные, профессиональные и релевантные для предприятия ответы при ответе на вопросы пользователей.

Использование документов по профессиональным областям и внутренних корпоративных документов из базы знаний, поддерживаемой администратором, повышает точность и прослеживаемость ответов ИИ-агентов.

Что такое RAG

RAG (Retrieval Augmented Generation) расшифровывается как «Retrieval-Augmented-Generation» (генерация с дополненным поиском).

- Поиск: Вопрос пользователя преобразуется в вектор с помощью модели эмбеддинга (например, BERT). Из векторной библиотеки извлекаются Top-K релевантных текстовых фрагментов с помощью плотного поиска (семантическое сходство) или разреженного поиска (совпадение по ключевым словам).

- Дополнение: Результаты поиска объединяются с исходным вопросом для формирования дополненного промпта (Prompt), который затем внедряется в контекстное окно LLM.

- Генерация: LLM использует дополненный промпт для генерации окончательного ответа, обеспечивая его фактическую точность и прослеживаемость.

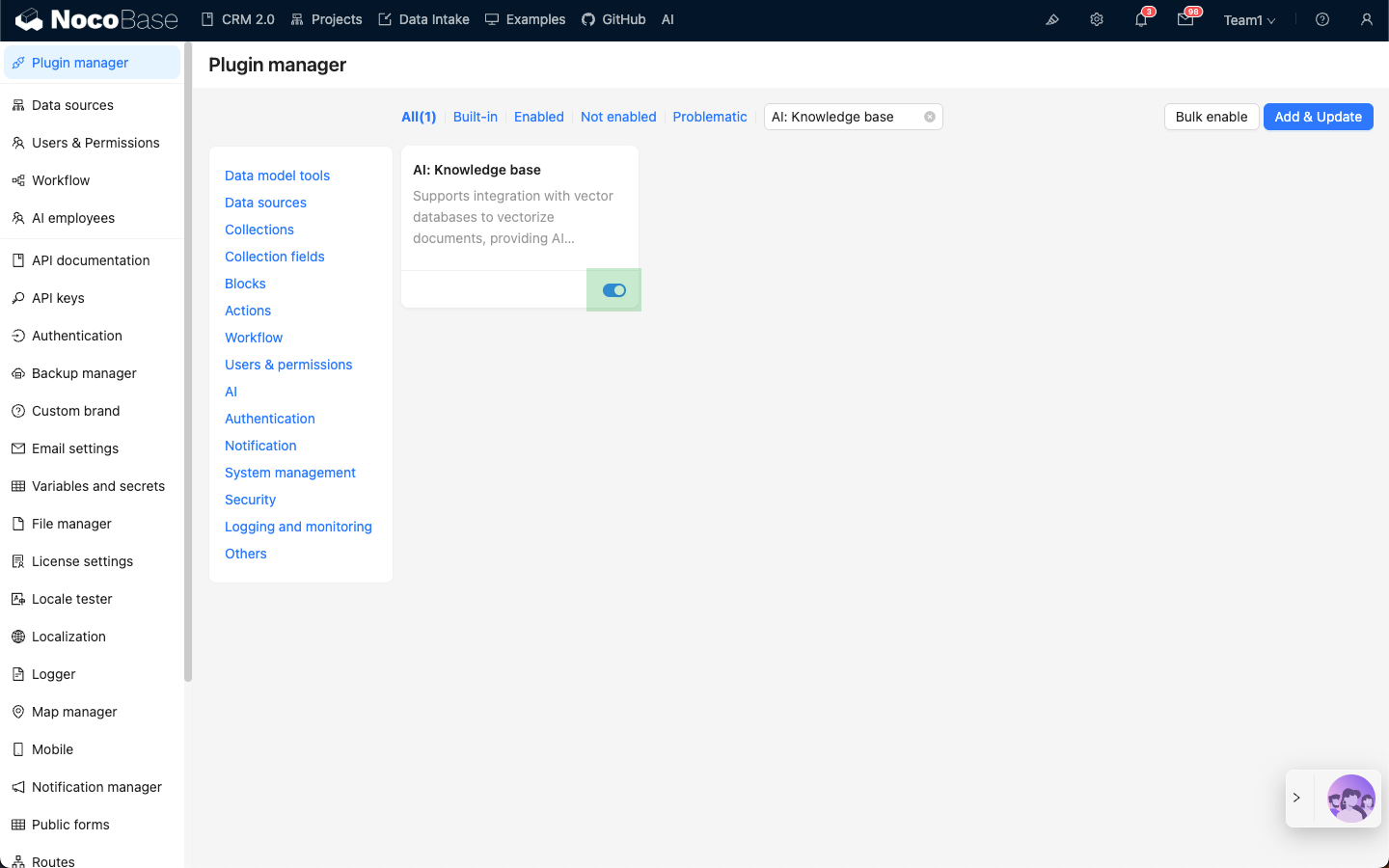

Установка

- Перейдите на страницу управления плагинами.

- Найдите плагин

AI: Knowledge baseи включите его.