यह दस्तावेज़ AI द्वारा अनुवादित किया गया है। किसी भी अशुद्धि के लिए, कृपया अंग्रेजी संस्करण देखें

संरचित आउटपुट

परिचय

कुछ एप्लिकेशन परिदृश्यों में, उपयोगकर्ता चाहते हैं कि LLM मॉडल JSON फ़ॉर्मेट में संरचित सामग्री के साथ प्रतिक्रिया दे। इसे "संरचित आउटपुट" को कॉन्फ़िगर करके प्राप्त किया जा सकता है।

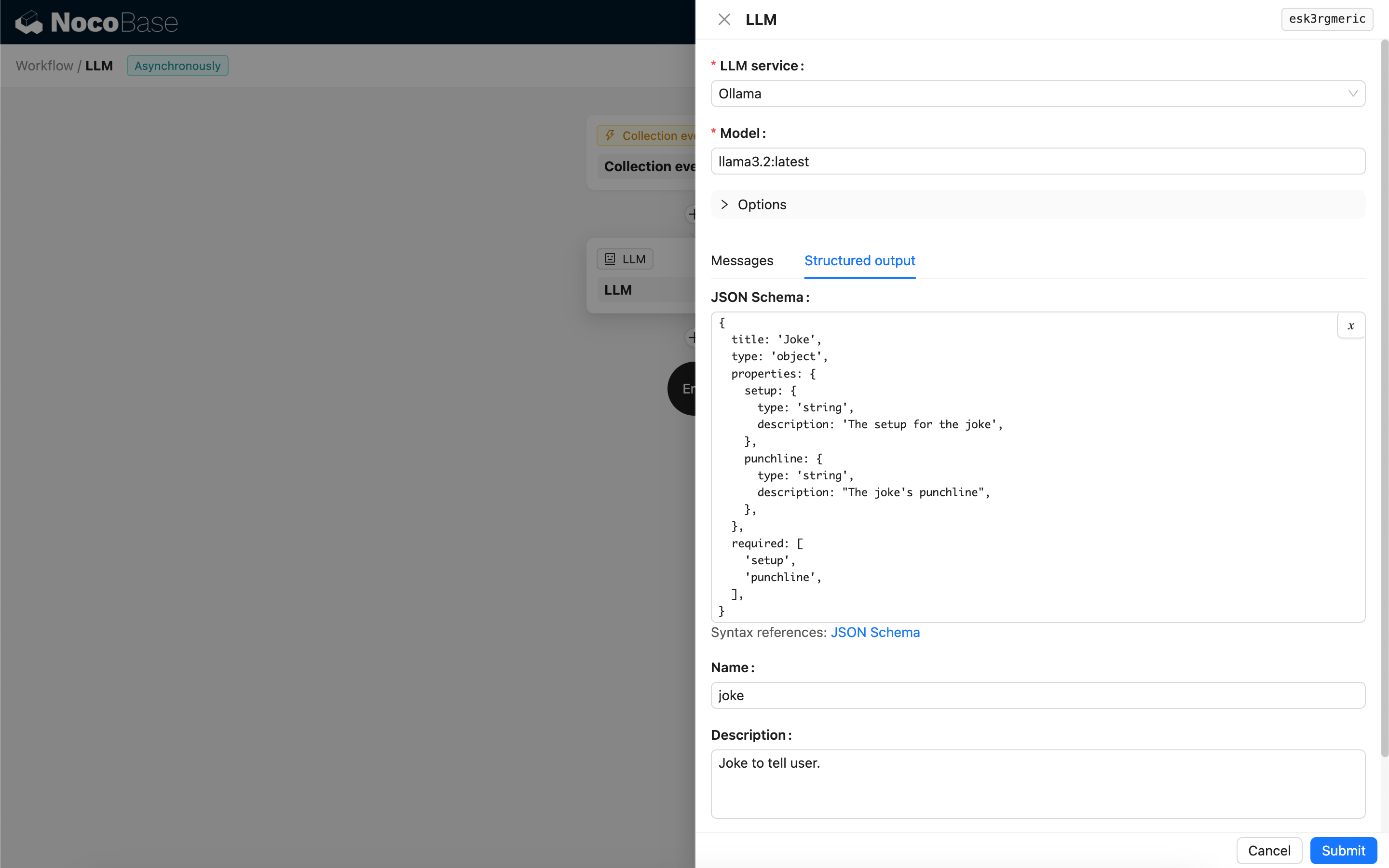

कॉन्फ़िगरेशन

- JSON Schema - आप JSON Schema को कॉन्फ़िगर करके मॉडल की प्रतिक्रिया की अपेक्षित संरचना निर्दिष्ट कर सकते हैं।

- नाम (Name) - वैकल्पिक, इसका उपयोग मॉडल को JSON Schema द्वारा दर्शाई गई वस्तु को बेहतर ढंग से समझने में मदद करने के लिए किया जाता है।

- विवरण (Description) - वैकल्पिक, इसका उपयोग मॉडल को JSON Schema के उद्देश्य को बेहतर ढंग से समझने में मदद करने के लिए किया जाता है।

- स्ट्रिक्ट (Strict) - यह मॉडल से JSON Schema संरचना के अनुसार सख्ती से प्रतिक्रिया उत्पन्न करने की अपेक्षा करता है। वर्तमान में, OpenAI के केवल कुछ नए मॉडल ही इस पैरामीटर का समर्थन करते हैं। इसे सक्षम करने से पहले कृपया पुष्टि करें कि आपका मॉडल संगत है या नहीं।

संरचित सामग्री उत्पन्न करने का तरीका

मॉडल द्वारा संरचित सामग्री उत्पन्न करने का तरीका उपयोग किए गए मॉडल और उसकी प्रतिक्रिया फ़ॉर्मेट (Response format) कॉन्फ़िगरेशन पर निर्भर करता है:

-

वे मॉडल जहाँ प्रतिक्रिया फ़ॉर्मेट (Response format) केवल

textका समर्थन करता है- कॉल किए जाने पर, नोड एक टूल को बाइंड करेगा जो JSON Schema के आधार पर JSON-फ़ॉर्मेटेड सामग्री उत्पन्न करता है, जिससे मॉडल को इस टूल को कॉल करके एक संरचित प्रतिक्रिया उत्पन्न करने में मार्गदर्शन मिलता है।

-

वे मॉडल जहाँ प्रतिक्रिया फ़ॉर्मेट (Response format) JSON मोड (

json_object) का समर्थन करता है- यदि कॉल किए जाने पर JSON मोड चुना जाता है, तो आपको प्रॉम्प्ट में मॉडल को स्पष्ट रूप से JSON फ़ॉर्मेट में वापस लौटने और प्रतिक्रिया फ़ील्ड के लिए विवरण प्रदान करने का निर्देश देना होगा।

- इस मोड में, JSON Schema का उपयोग केवल मॉडल द्वारा लौटाई गई JSON स्ट्रिंग को पार्स करने और उसे लक्ष्य JSON ऑब्जेक्ट में बदलने के लिए किया जाता है।

-

वे मॉडल जहाँ प्रतिक्रिया फ़ॉर्मेट (Response format) JSON Schema (

json_schema) का समर्थन करता है- JSON Schema का उपयोग सीधे मॉडल के लिए लक्ष्य प्रतिक्रिया संरचना को निर्दिष्ट करने के लिए किया जाता है।

- वैकल्पिक स्ट्रिक्ट (Strict) पैरामीटर मॉडल से प्रतिक्रिया उत्पन्न करते समय JSON Schema का सख्ती से पालन करने की अपेक्षा करता है।

-

Ollama स्थानीय मॉडल

- यदि JSON Schema कॉन्फ़िगर किया गया है, तो कॉल किए जाने पर नोड इसे

formatपैरामीटर के रूप में मॉडल को पास करेगा।

- यदि JSON Schema कॉन्फ़िगर किया गया है, तो कॉल किए जाने पर नोड इसे

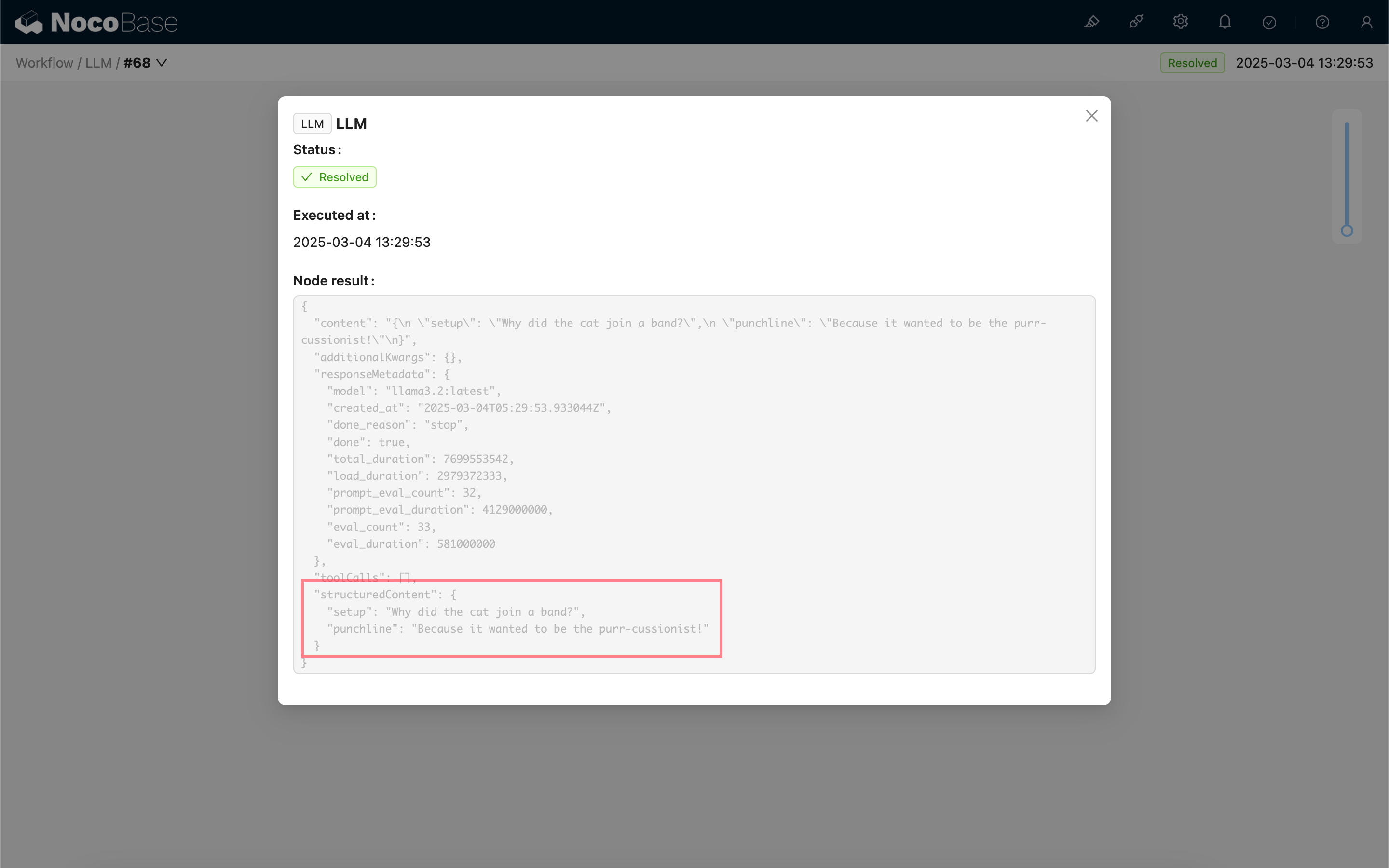

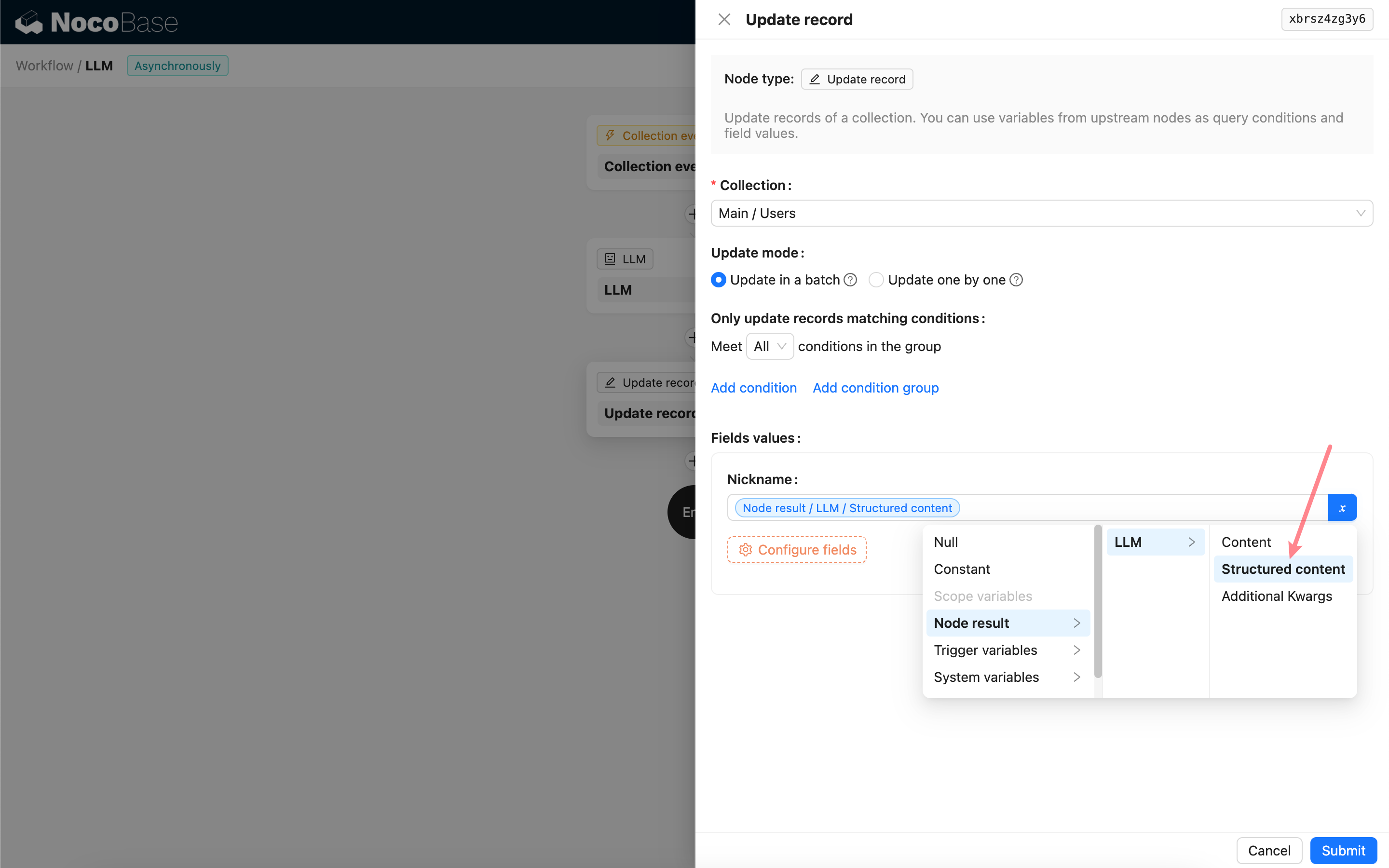

संरचित आउटपुट परिणाम का उपयोग करना

मॉडल की प्रतिक्रिया की संरचित सामग्री नोड के 'संरचित सामग्री (Structured content)' फ़ील्ड में एक JSON ऑब्जेक्ट के रूप में सहेजी जाती है और बाद के नोड्स द्वारा इसका उपयोग किया जा सकता है।