Tento dokument byl přeložen umělou inteligencí. V případě nepřesností se prosím obraťte na anglickou verzi

Textový chat

This feature is provided by the plugin «AI zaměstnanci»Úvod

Pomocí LLM uzlu v pracovním postupu můžete zahájit konverzaci s online službou LLM. Využijete tak schopnosti velkých modelů k podpoře a dokončení řady obchodních procesů.

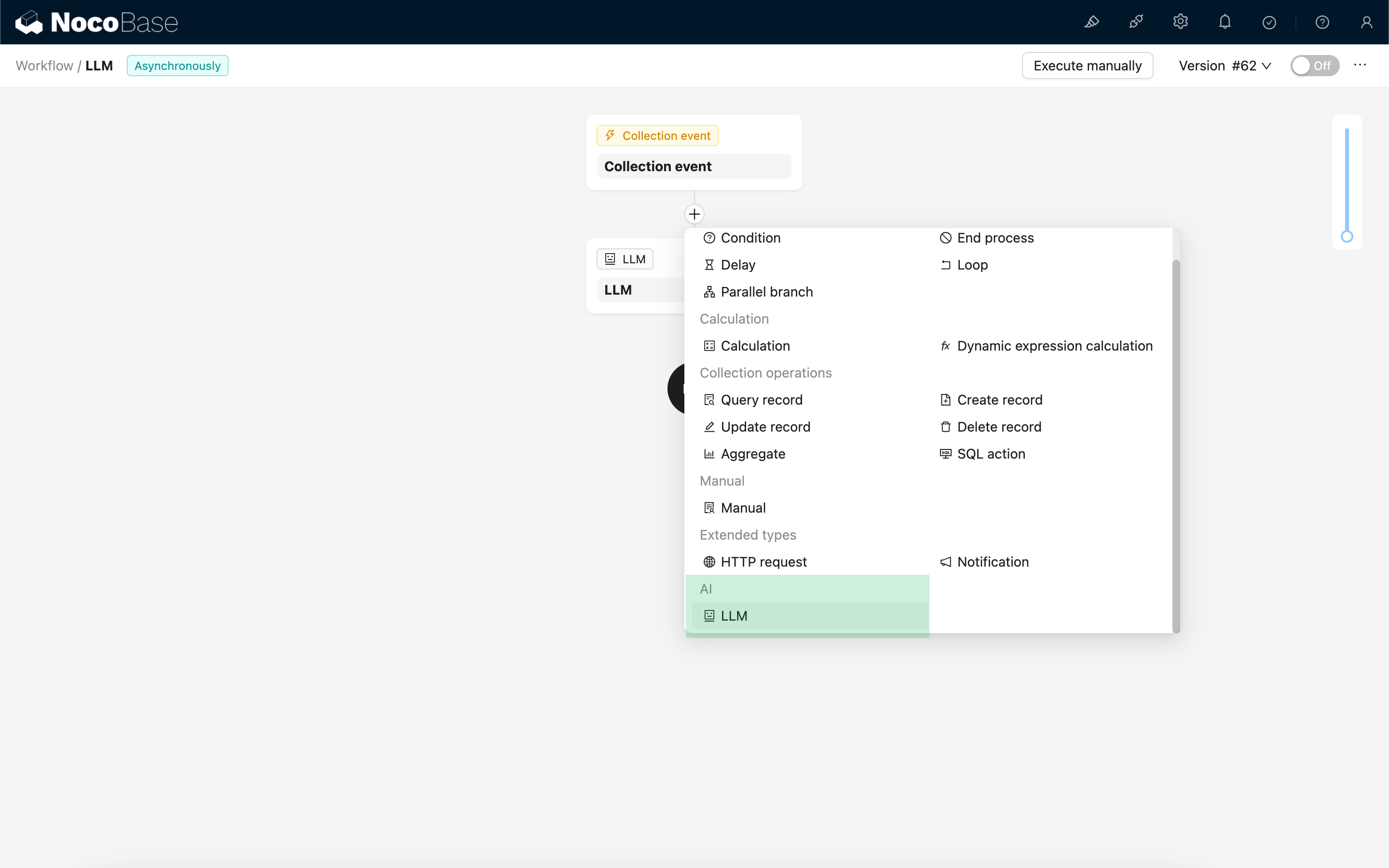

Vytvoření LLM uzlu

Vzhledem k tomu, že konverzace se službami LLM jsou často časově náročné, lze LLM uzel použít pouze v asynchronních pracovních postupech.

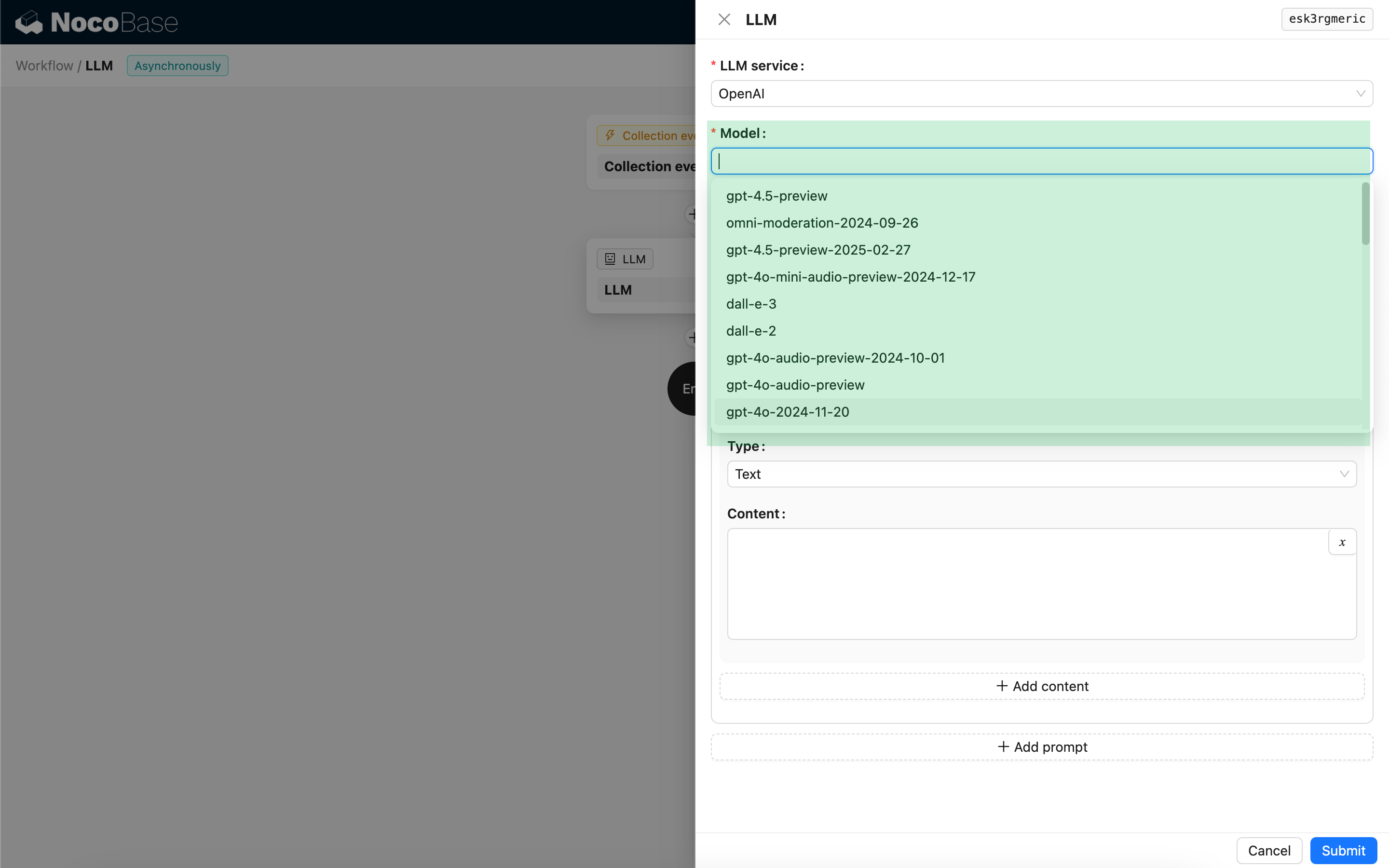

Výběr modelu

Nejprve vyberte připojenou službu LLM. Pokud ještě nemáte připojenou žádnou službu LLM, musíte nejprve přidat její konfiguraci. Viz: Správa služeb LLM

Po výběru služby se aplikace pokusí získat seznam dostupných modelů ze služby LLM, abyste si mohli vybrat. Některé online služby LLM mohou mít API pro získávání modelů, která neodpovídají standardním API protokolům; v takových případech můžete ID modelu zadat i ručně.

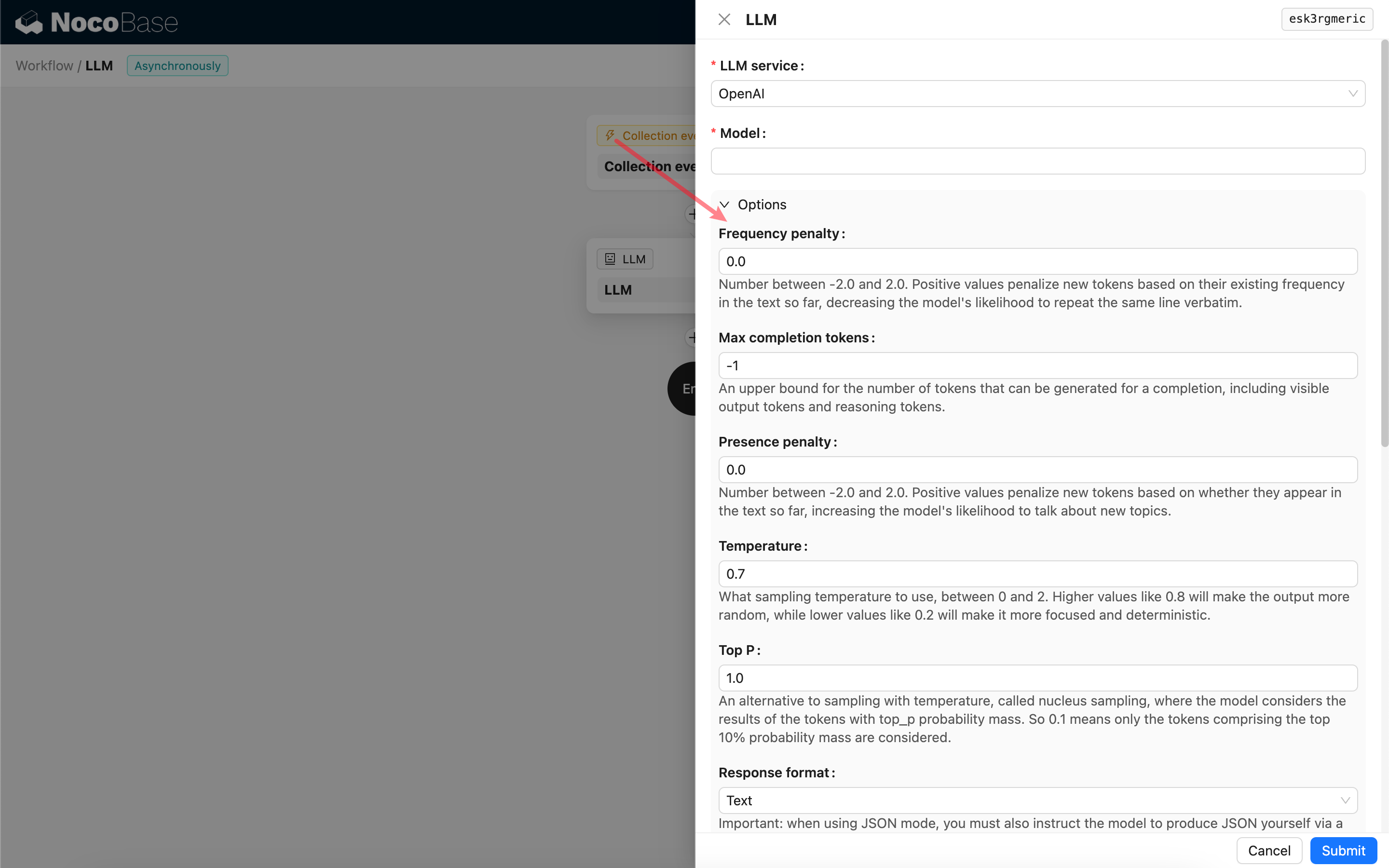

Nastavení parametrů volání

Můžete upravit parametry pro volání LLM modelu podle potřeby.

Response format

Za zmínku stojí nastavení Response format. Tato volba slouží k určení formátu odpovědi velkého modelu, který může být textový nebo JSON. Pokud zvolíte režim JSON, mějte na paměti následující:

- Odpovídající LLM model musí podporovat volání v režimu JSON. Kromě toho musíte v promptu explicitně vyzvat LLM, aby odpověděl ve formátu JSON, například: "Tell me a joke about cats, respond in JSON with `setup` and `punchline` keys". Jinak nemusí být žádná odpověď, což povede k chybě

400 status code (no body). - Odpověď bude JSON řetězec. Abyste mohli použít jeho strukturovaný obsah, musíte jej analyzovat pomocí schopností jiných uzlů pracovního postupu. Můžete také použít funkci Strukturovaný výstup.

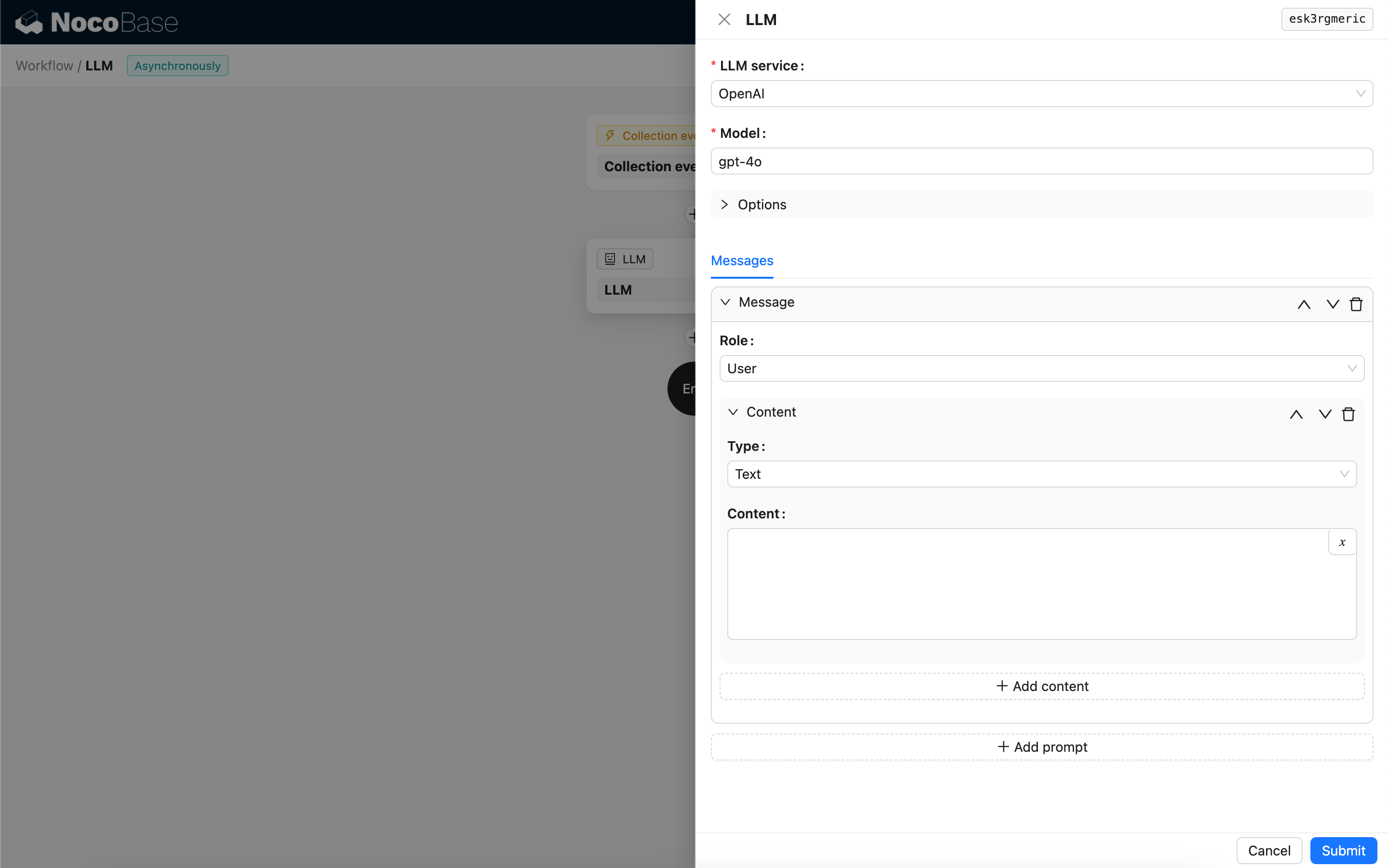

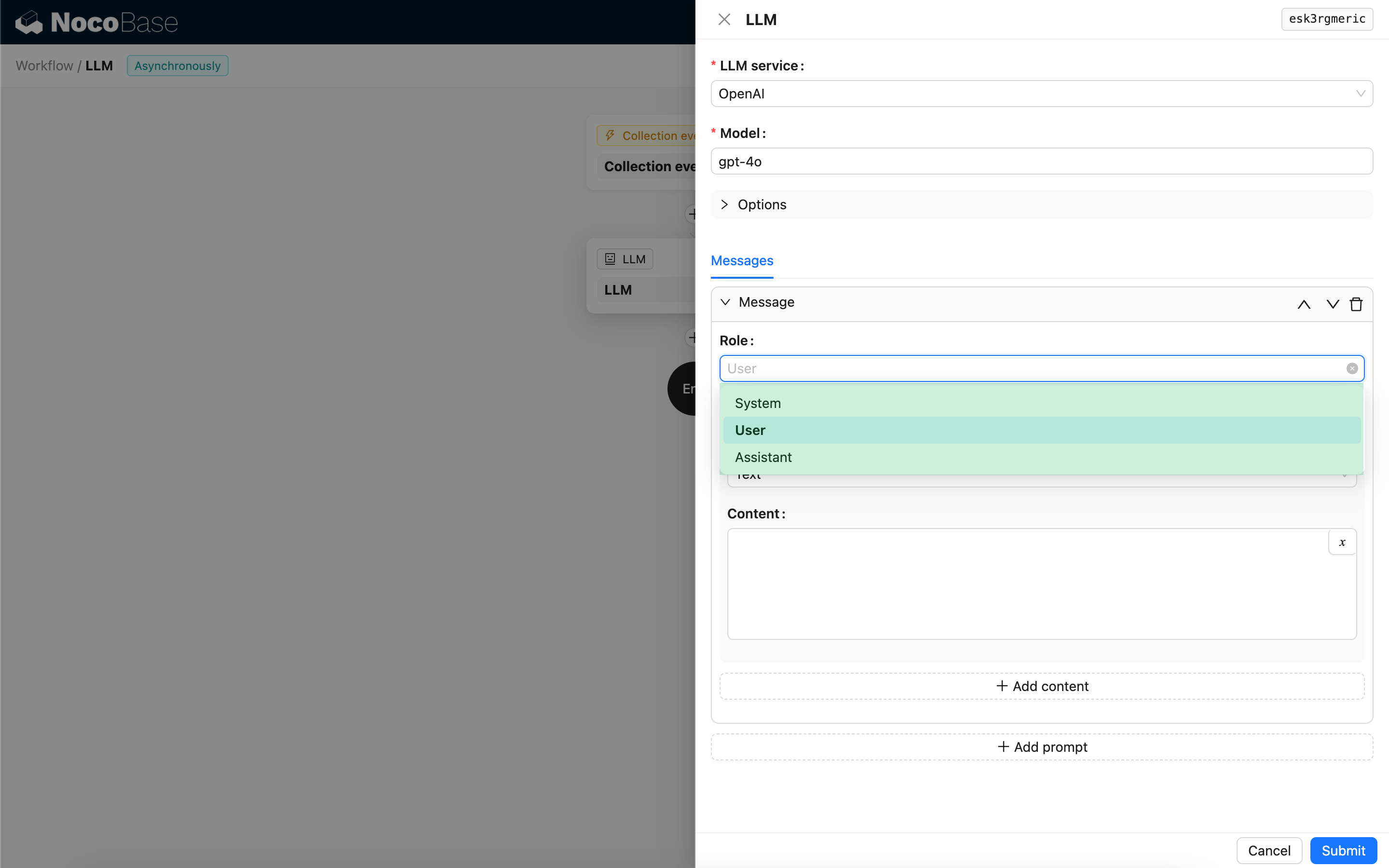

Zprávy

Pole zpráv odeslaných LLM modelu může zahrnovat sadu historických zpráv. Zprávy podporují tři typy:

- System – Obvykle se používá k definování role a chování LLM modelu v konverzaci.

- User – Obsah zadaný uživatelem.

- Assistant – Obsah, kterým model odpověděl.

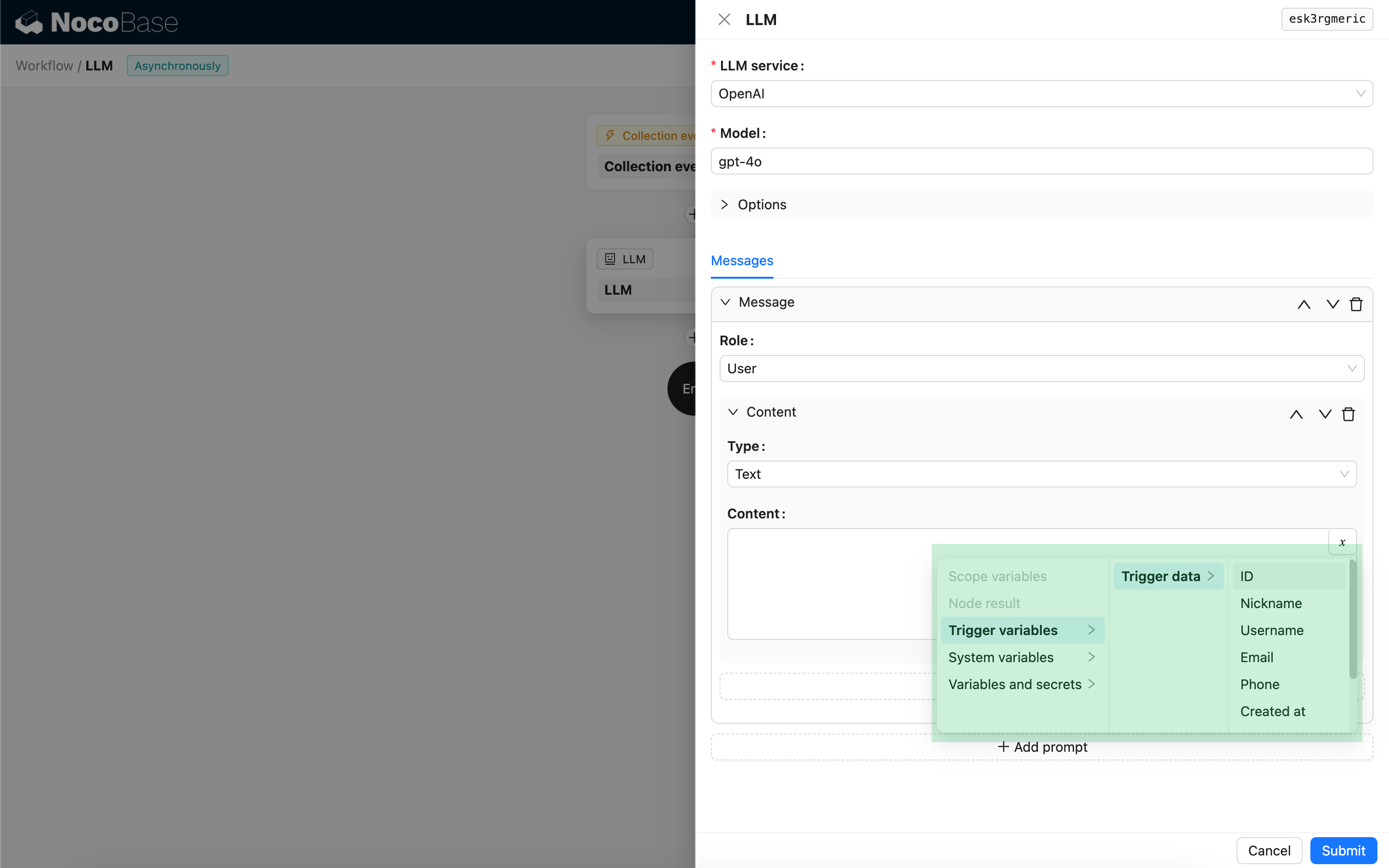

U uživatelských zpráv, za předpokladu, že to model podporuje, můžete do jednoho promptu přidat více částí obsahu, odpovídajících parametru content. Pokud model, který používáte, podporuje parametr content pouze jako řetězec (což platí pro většinu modelů, které nepodporují multimodální konverzace), rozdělte zprávu do více promptů, přičemž každý prompt obsahuje pouze jednu část obsahu. Tímto způsobem uzel odešle obsah jako řetězec.

V obsahu zprávy můžete použít proměnné k odkazování na kontext pracovního postupu.

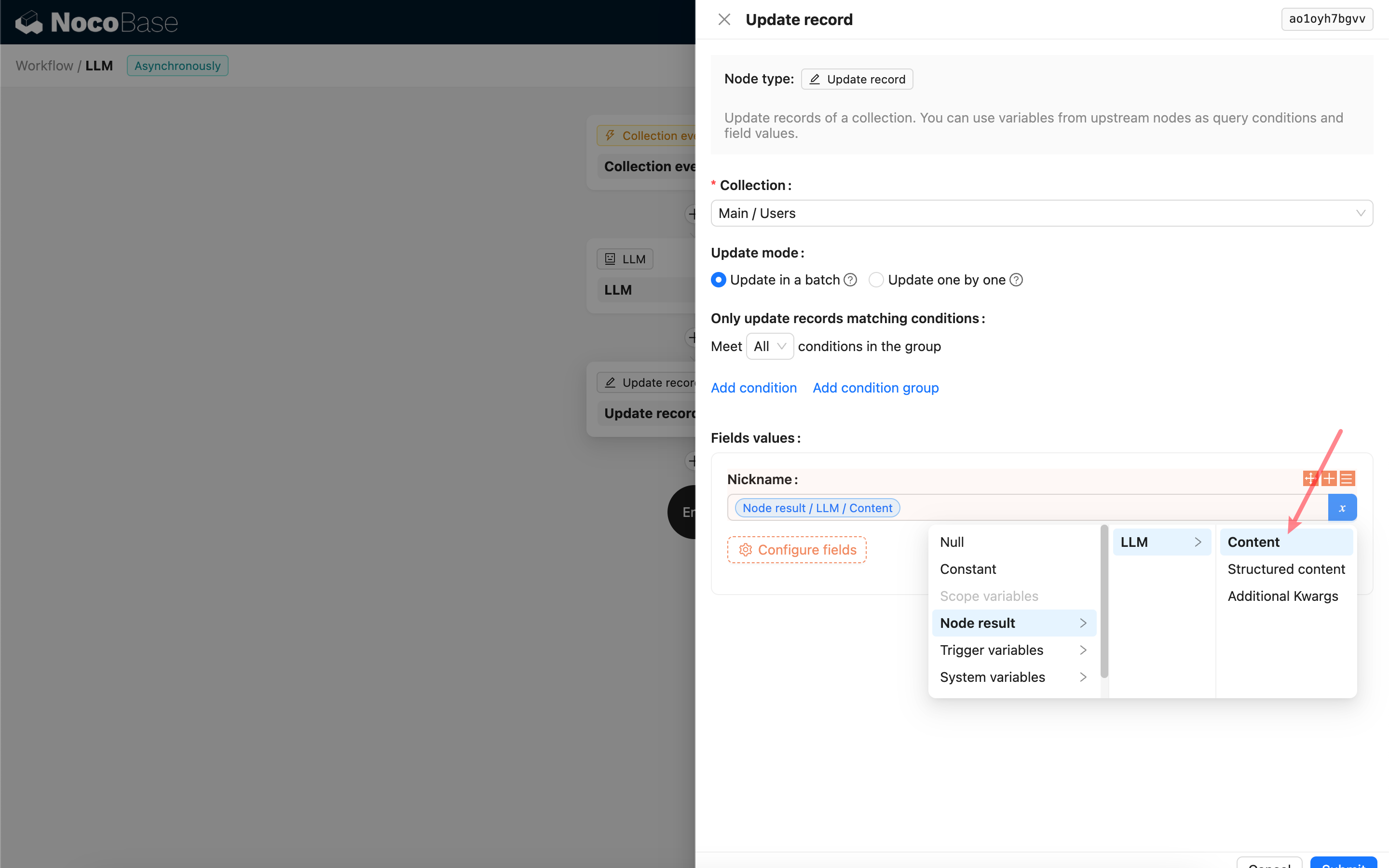

Použití obsahu odpovědi LLM uzlu

Obsah odpovědi LLM uzlu můžete použít jako proměnnou v jiných uzlech.