このドキュメントはAIによって翻訳されました。不正確な情報については、英語版をご参照ください

テキストチャット

This feature is provided by the plugin «AI 従業員»はじめに

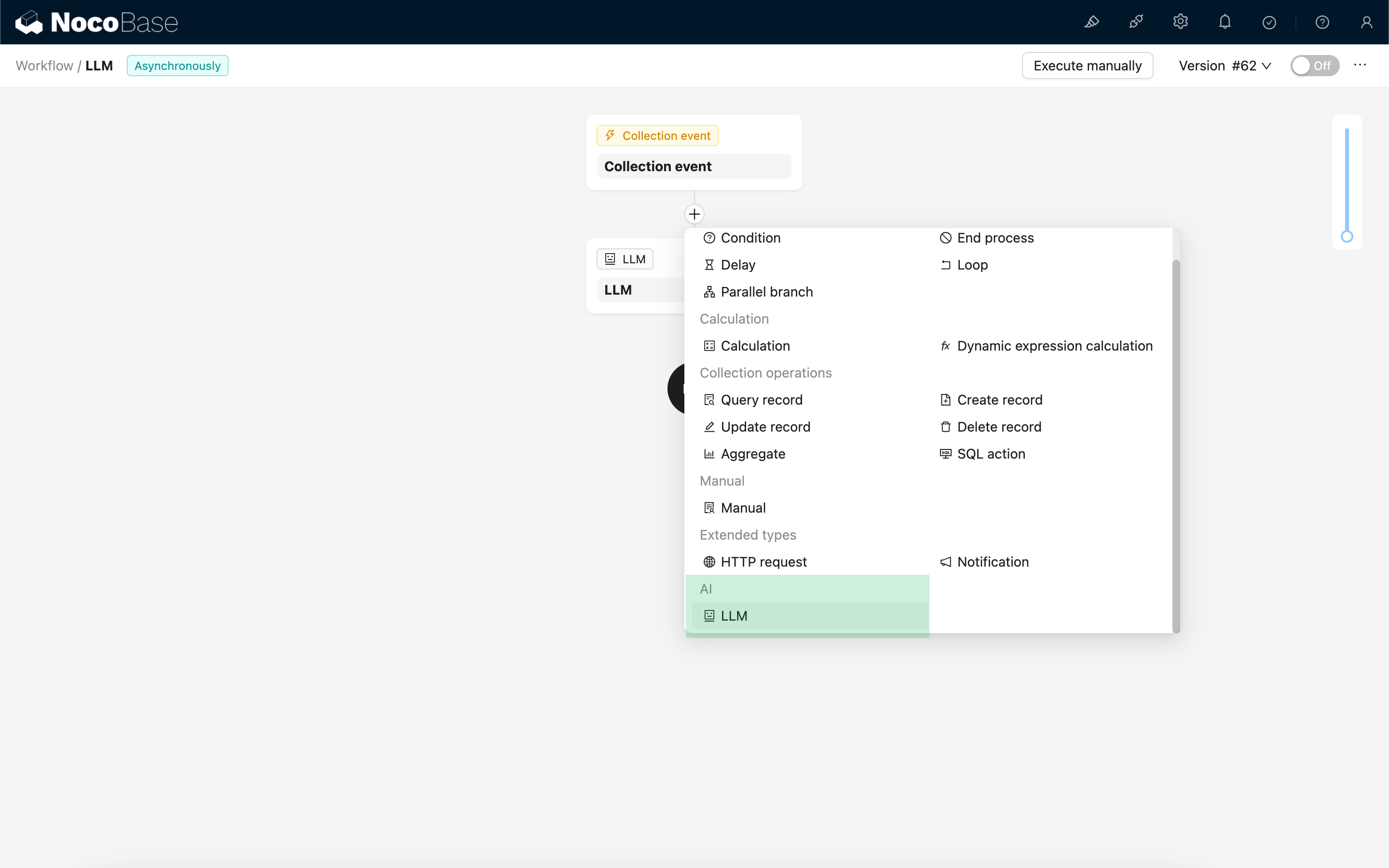

ワークフローのLLMノードを使用すると、オンラインのLLMサービスと会話を開始し、大規模モデルの能力を活用して一連のビジネスプロセスを支援できます。

LLMノードの作成

LLMサービスとの会話は一般的に時間がかかるため、LLMノードは非同期ワークフローでのみ使用可能です。

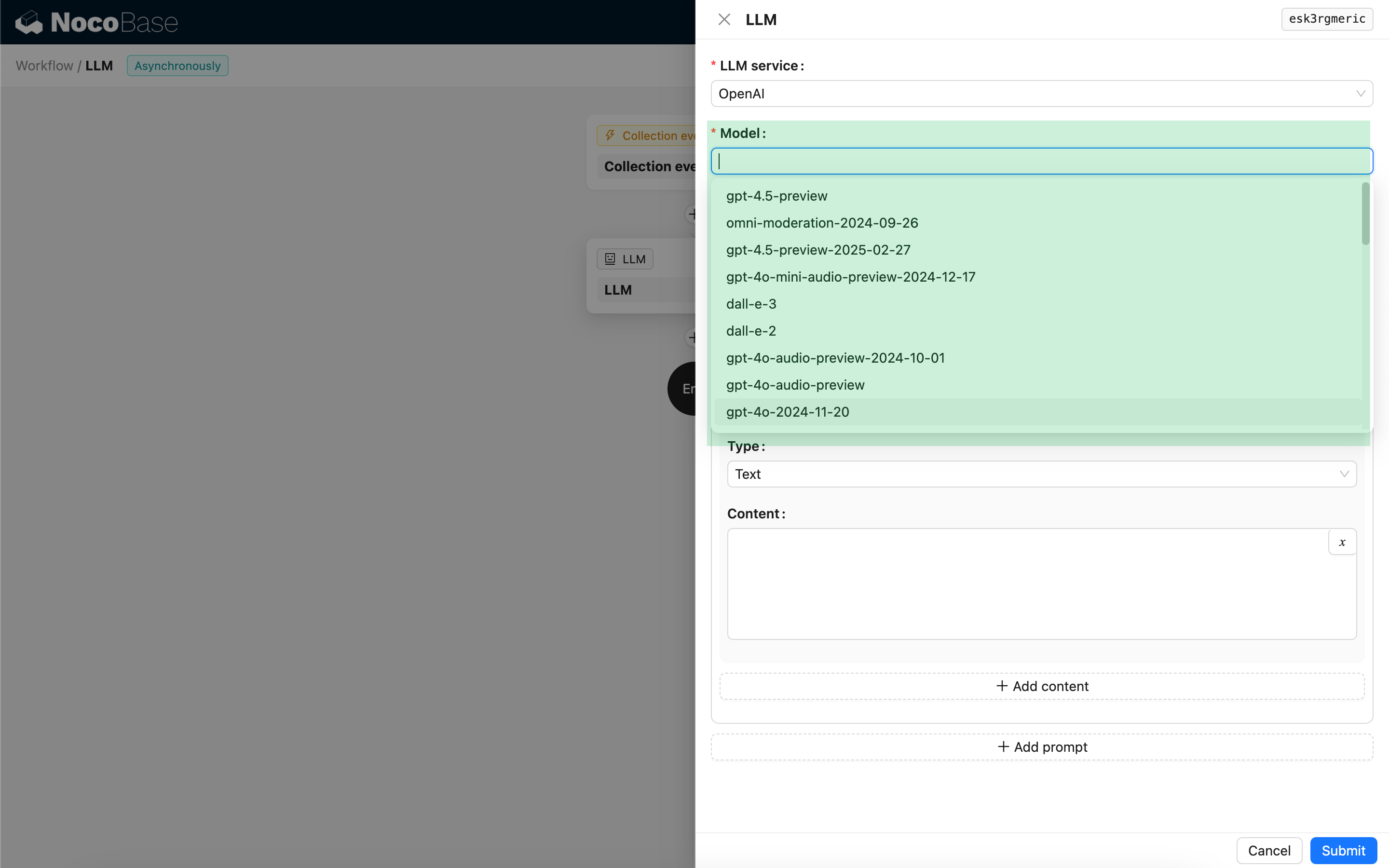

モデルの選択

まず、接続済みのLLMサービスを選択します。まだLLMサービスが接続されていない場合は、先にLLMサービスの設定を追加する必要があります。参照:LLM サービス管理

サービスを選択すると、アプリケーションはLLMサービスから利用可能なモデルのリストを取得し、選択肢として表示します。一部のオンラインLLMサービスでは、モデル取得用のAPIが標準のAPIプロトコルに準拠していない場合があります。その場合、ユーザーは手動でモデルIDを入力することもできます。

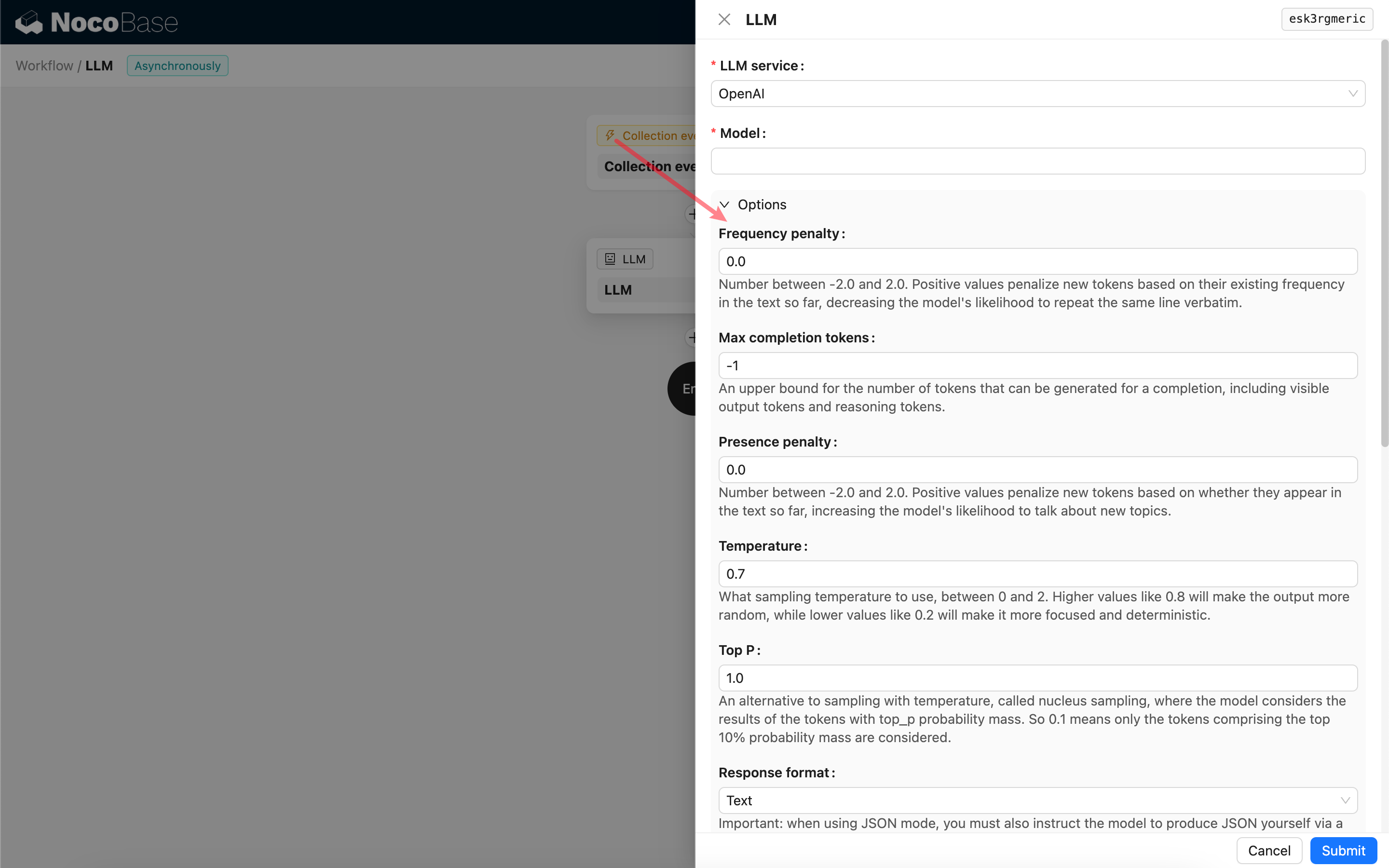

呼び出しパラメーターの設定

必要に応じて、LLMモデルを呼び出すためのパラメーターを調整できます。

レスポンスフォーマット

特に注目すべきは、レスポンスフォーマットの設定です。この設定項目は、大規模モデルにレスポンスの内容形式(テキストまたはJSON)を指示するために使用されます。JSONモードを選択した場合、以下の点に注意してください。

- 対応するLLMモデルがJSONモードでの呼び出しをサポートしている必要があります。また、ユーザーはプロンプト内でLLMにJSON形式で応答するよう明確に指示する必要があります。例えば、「Tell me a joke about cats, respond in JSON with `setup` and `punchline` keys」のように指定します。そうしないと、応答結果が得られず、`400 status code (no body)`のエラーが発生する可能性があります。

- 応答結果はJSON文字列です。ユーザーは、その構造化された内容を使用するために、ワークフローの他のノードの機能を利用して解析する必要があります。また、構造化出力機能を使用することもできます。

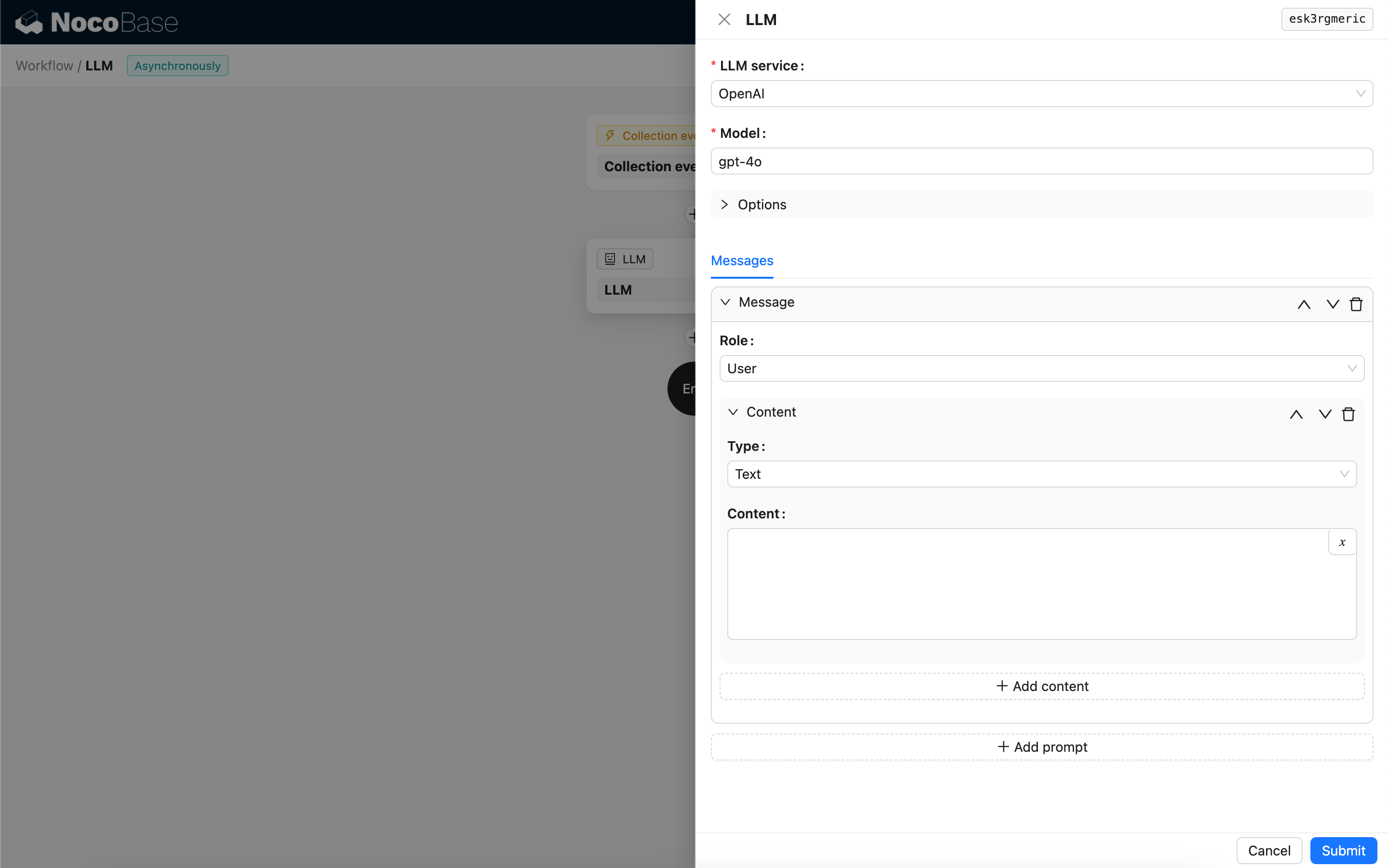

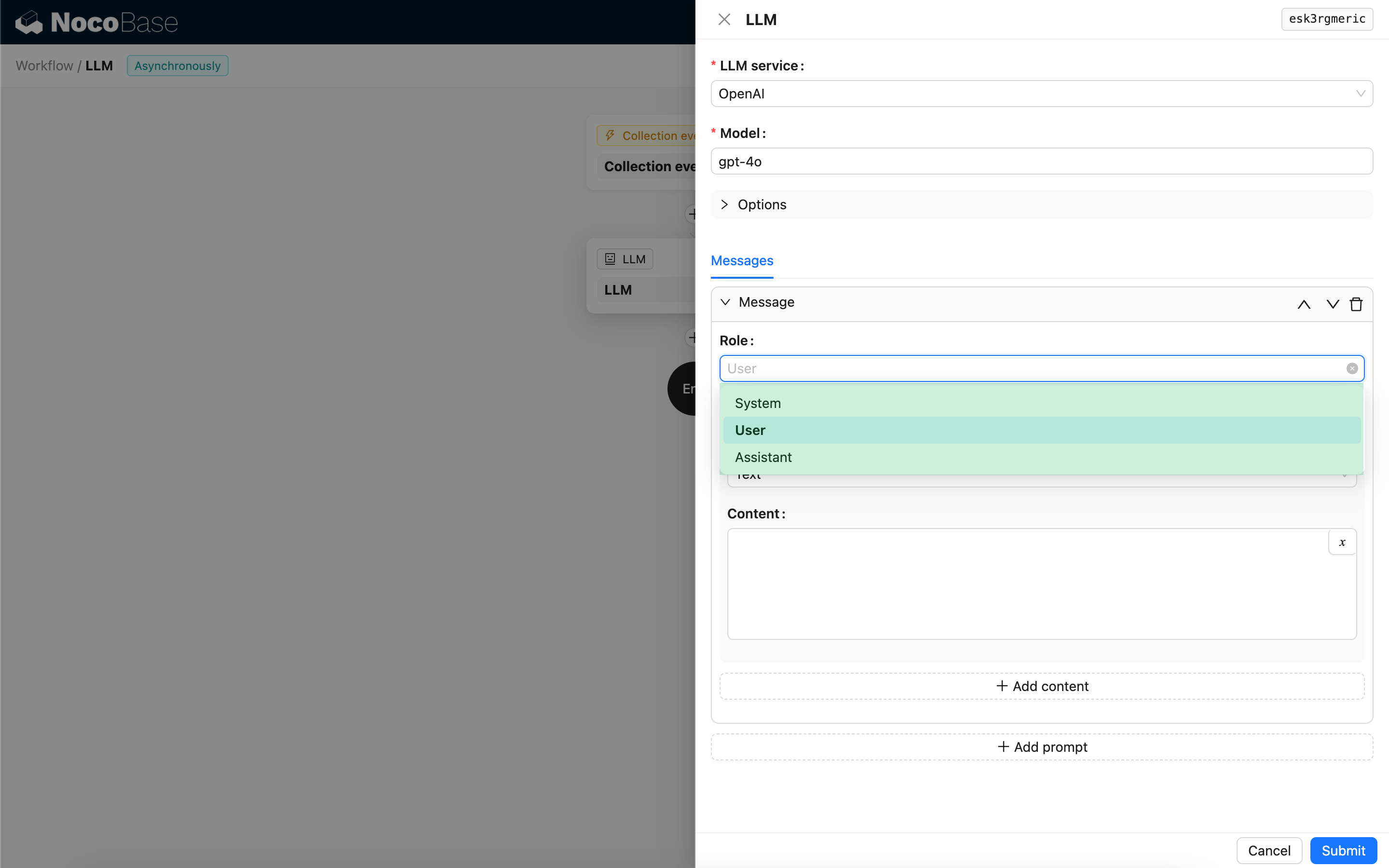

メッセージ

LLMモデルに送信されるメッセージの配列には、一連の履歴メッセージを含めることができます。メッセージは以下の3つのタイプをサポートしています。

- System - 通常、会話におけるLLMモデルの役割と振る舞いを定義するために使用されます。

- User - ユーザーが入力する内容です。

- Assistant - モデルが応答する内容です。

ユーザーメッセージについては、モデルがサポートしている場合、`content`パラメーターに対応する複数の内容を1つのプロンプトに追加できます。使用しているモデルが`content`パラメーターを文字列形式でのみサポートしている場合(ほとんどのマルチモーダル会話をサポートしないモデルがこれに該当します)、メッセージを複数のプロンプトに分割し、各プロンプトに1つの内容のみを含めてください。これにより、ノードは内容を文字列として送信します。

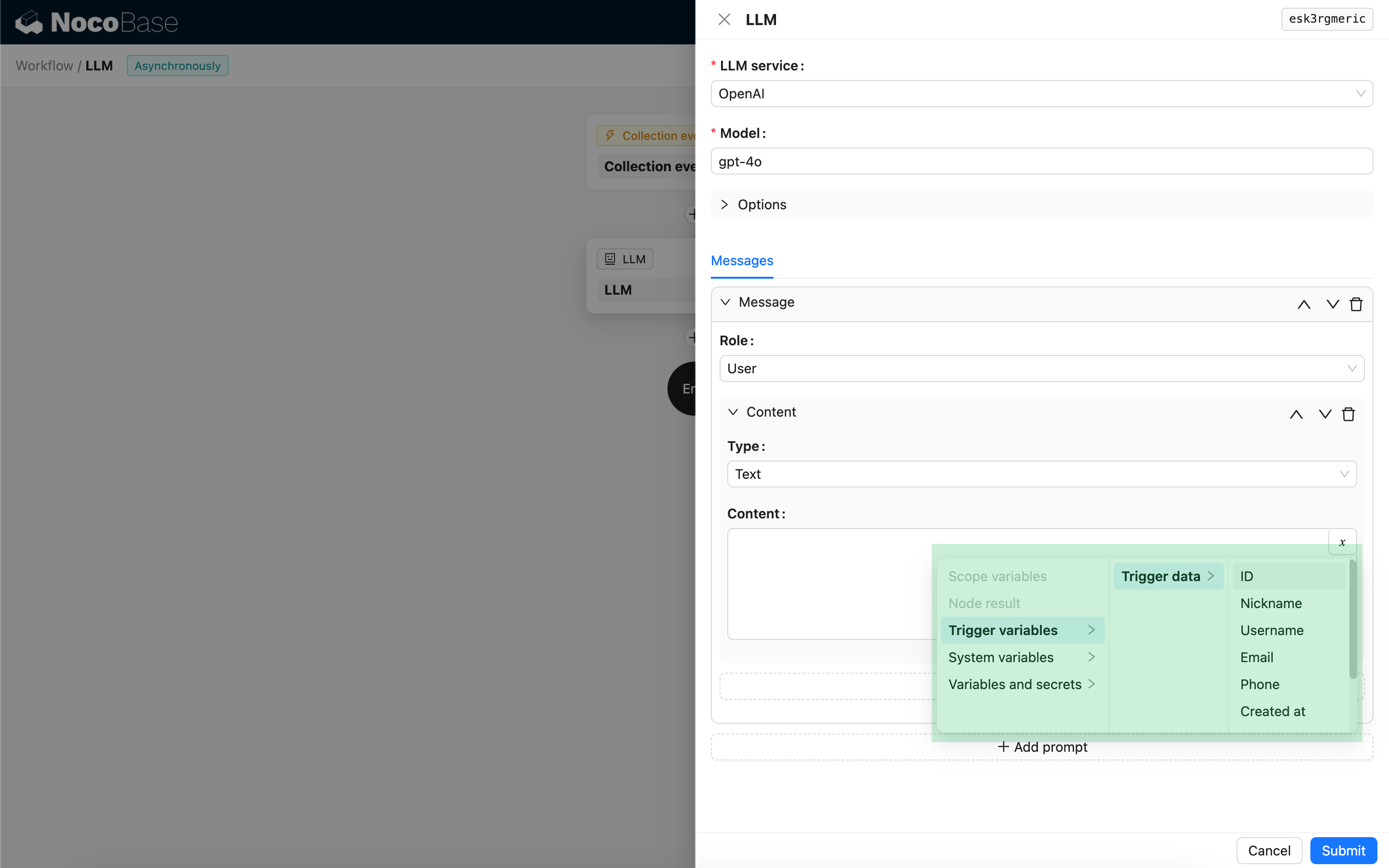

メッセージの内容では、ワークフローのコンテキストを参照するために変数を使用できます。

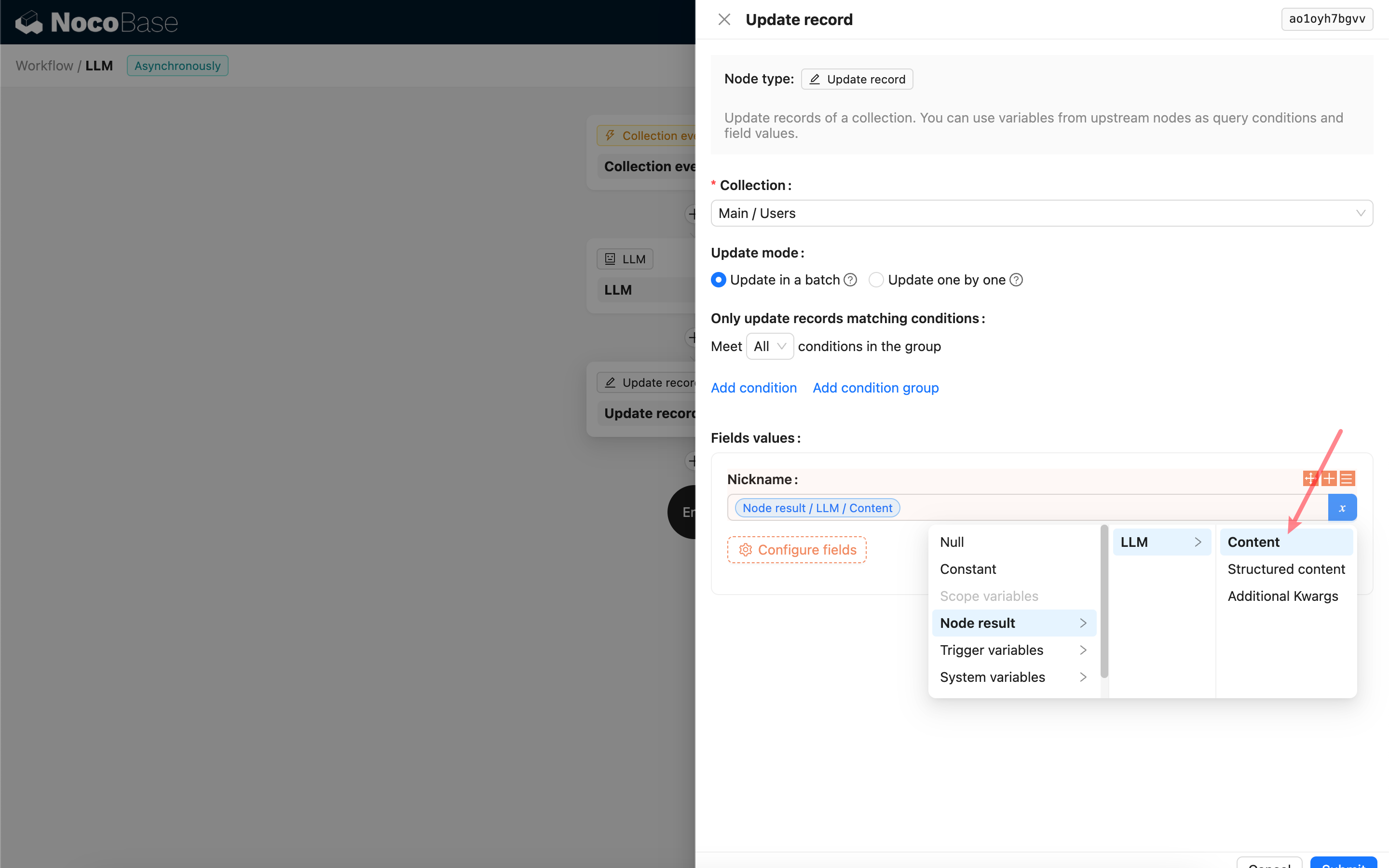

LLMノードの応答内容の使用

LLMノードの応答内容を、他のノードで変数として使用できます。