Ten dokument został przetłumaczony przez AI. W przypadku niedokładności, proszę odnieść się do wersji angielskiej

Szybki start

Wprowadzenie

Zanim zaczną Państwo korzystać z Pracownika AI, należy podłączyć usługę LLM online. NocoBase obecnie wspiera popularne usługi LLM online, takie jak OpenAI, Gemini, Claude, DepSeek, Qwen itp. Oprócz usług LLM online, NocoBase obsługuje również podłączanie lokalnych modeli Ollama.

Konfiguracja usługi LLM

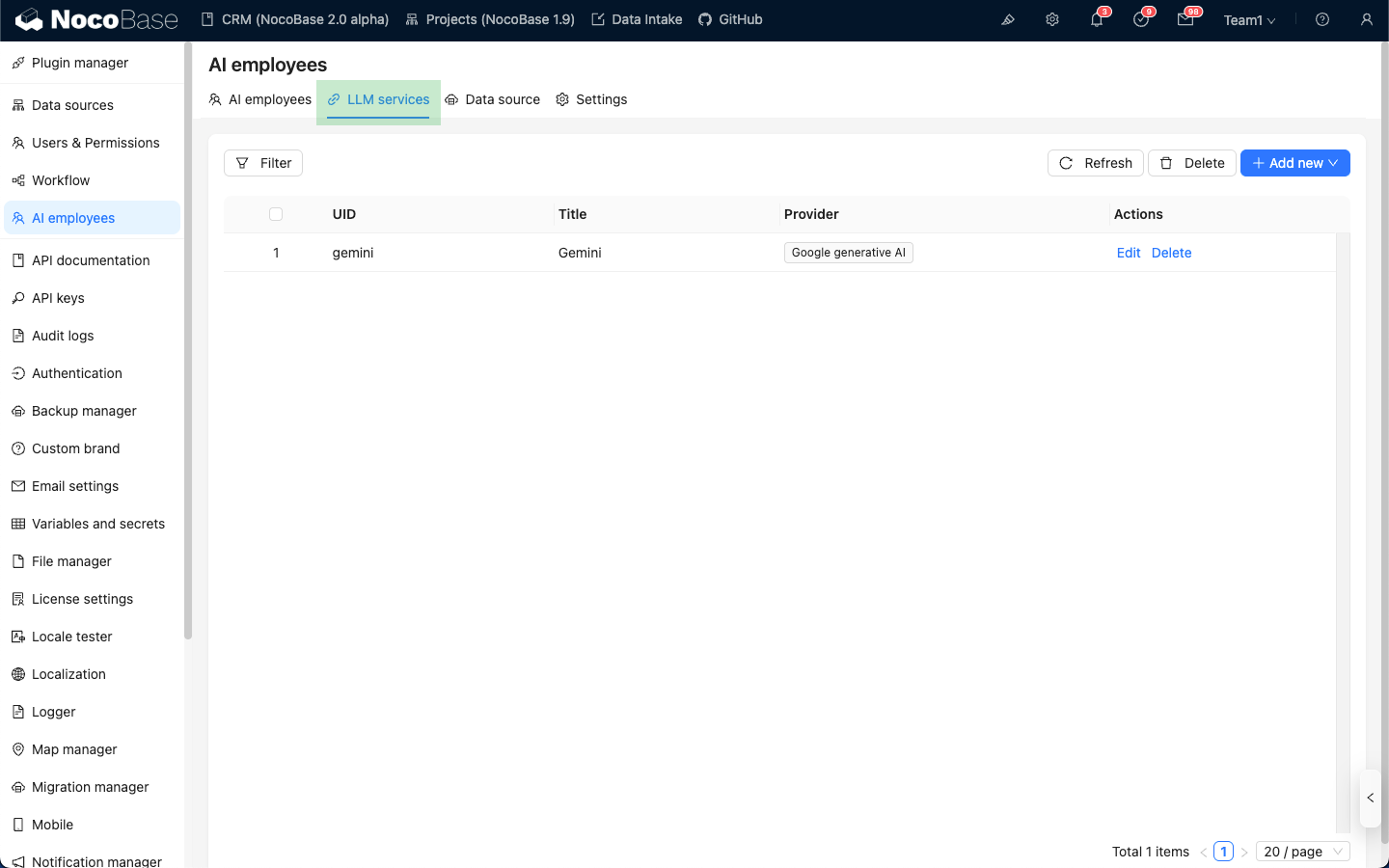

Proszę przejść do strony konfiguracji wtyczki Pracownik AI, a następnie kliknąć zakładkę LLM service, aby przejść do strony zarządzania usługami LLM.

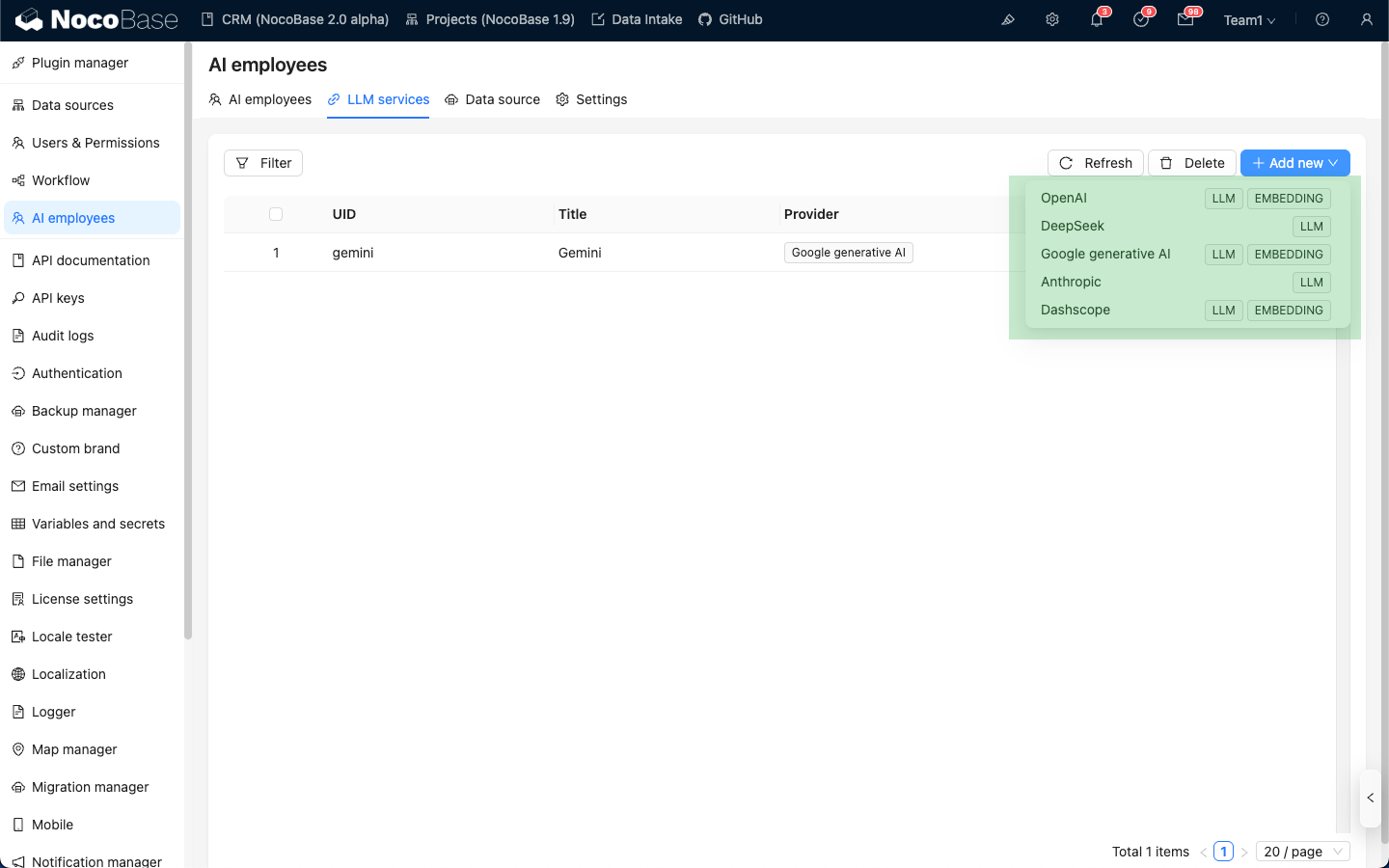

Proszę najechać kursorem na przycisk Add New w prawym górnym rogu listy usług LLM i wybrać usługę LLM, której chcą Państwo użyć.

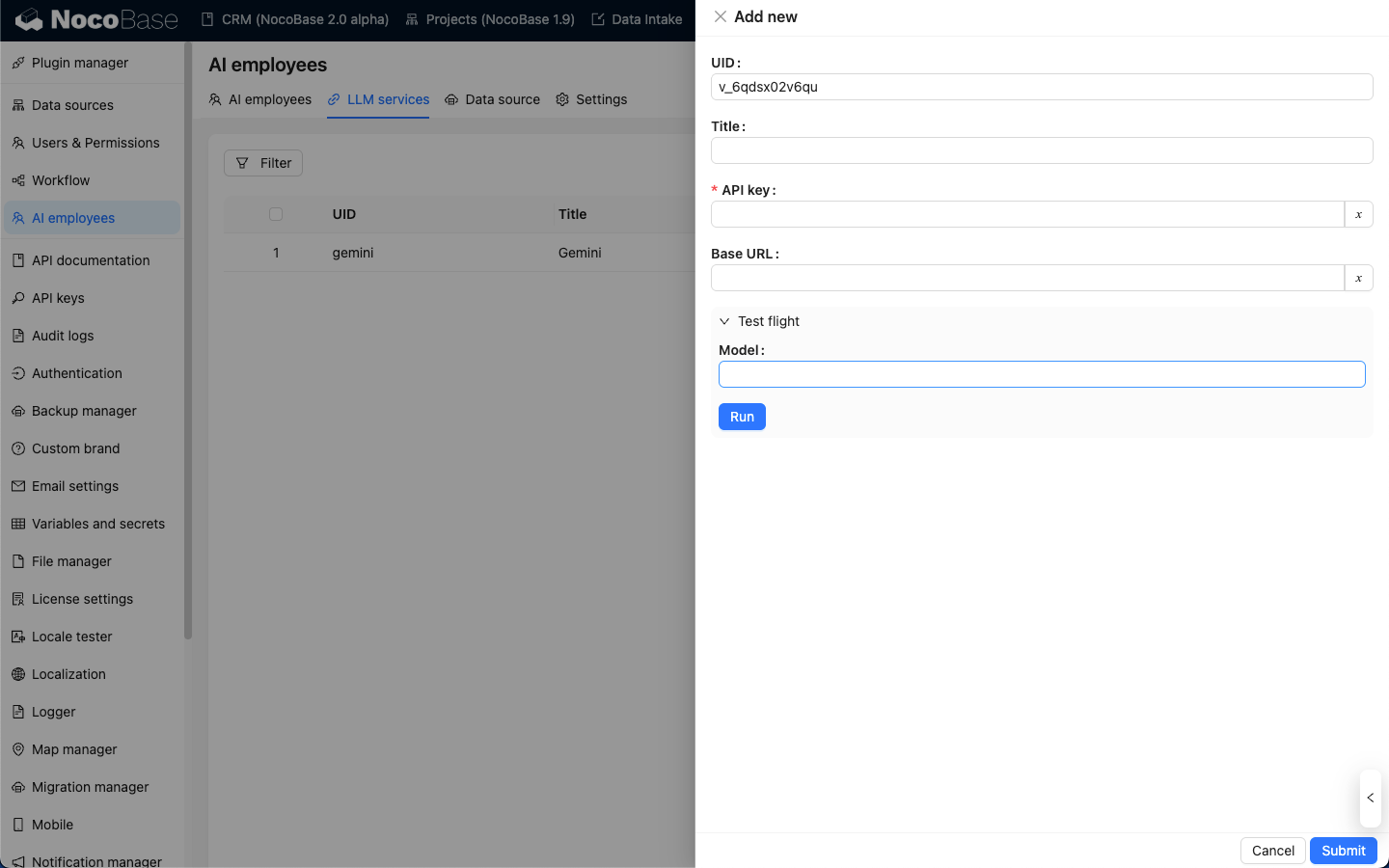

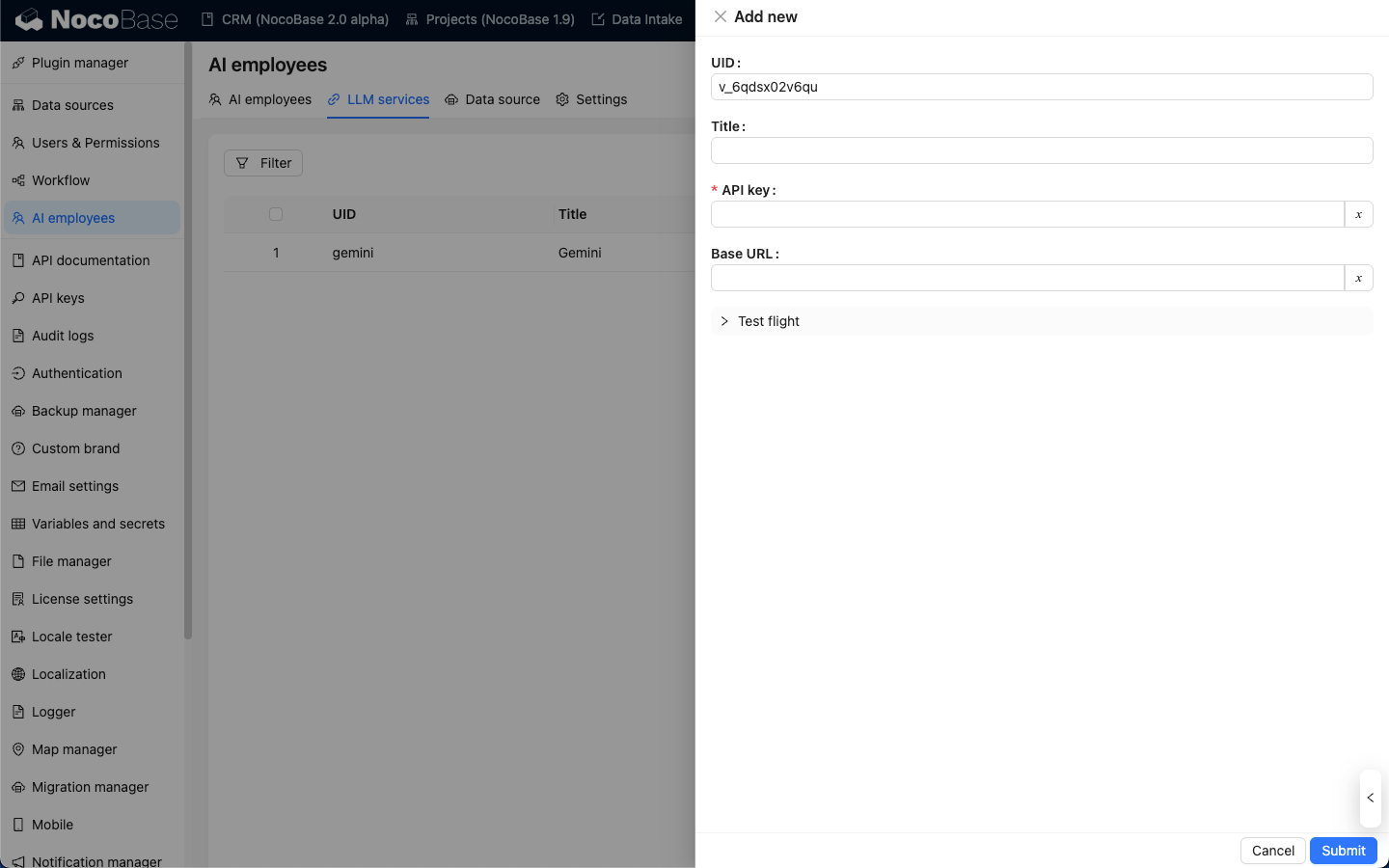

Na przykładzie OpenAI, w wyskakującym okienku proszę wpisać łatwy do zapamiętania title, następnie wprowadzić API key uzyskany z OpenAI i kliknąć Submit, aby zapisać. W ten sposób zakończą Państwo konfigurację usługi LLM.

Pole Base URL zazwyczaj można pozostawić puste. Jeśli korzystają Państwo z zewnętrznej usługi LLM kompatybilnej z API OpenAI, proszę wypełnić odpowiednie pole Base URL.

Test dostępności

Na stronie konfiguracji usługi LLM proszę kliknąć przycisk Test flight, wpisać nazwę modelu, którego chcą Państwo użyć, a następnie kliknąć przycisk Run, aby sprawdzić, czy usługa LLM i model są dostępne.