TIP

Detta dokument har översatts av AI. För eventuella felaktigheter, se den engelska versionen

Vektorlagring

Introduktion

I en kunskapsbas behöver ni, både när ni sparar dokument (för att vektorisera dem) och när ni söker efter dokument (för att vektorisera söktermerna), använda en Embedding model för att vektorisera den ursprungliga texten.

I AI-kunskapsbas-pluginet är en vektorlagring en koppling mellan en Embedding model och en vektordatabas.

Hantering av vektorlagring

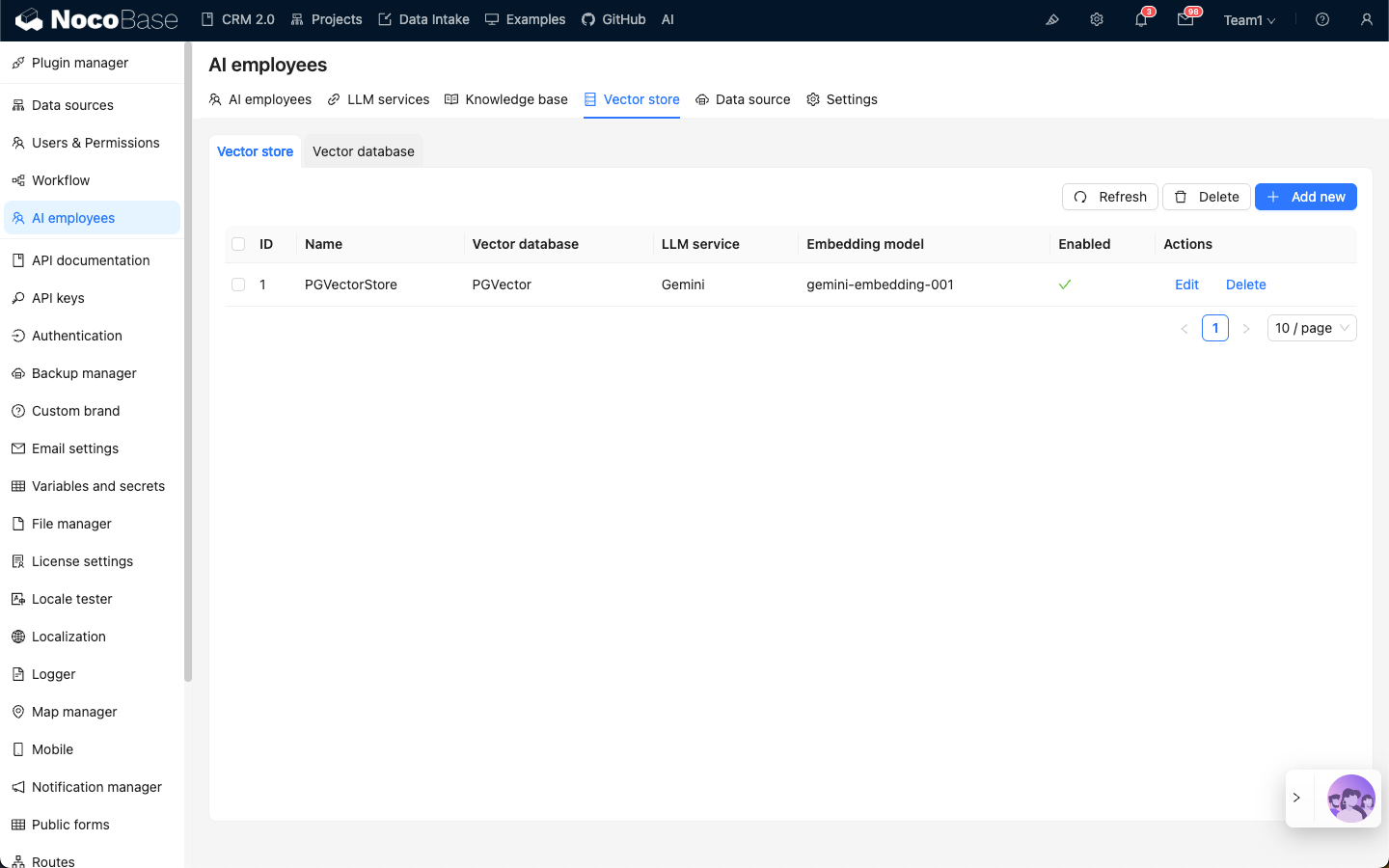

Gå till konfigurationssidan för AI-medarbetar-pluginet, klicka på fliken Vector store och välj Vector store för att komma till sidan för hantering av vektorlagring.

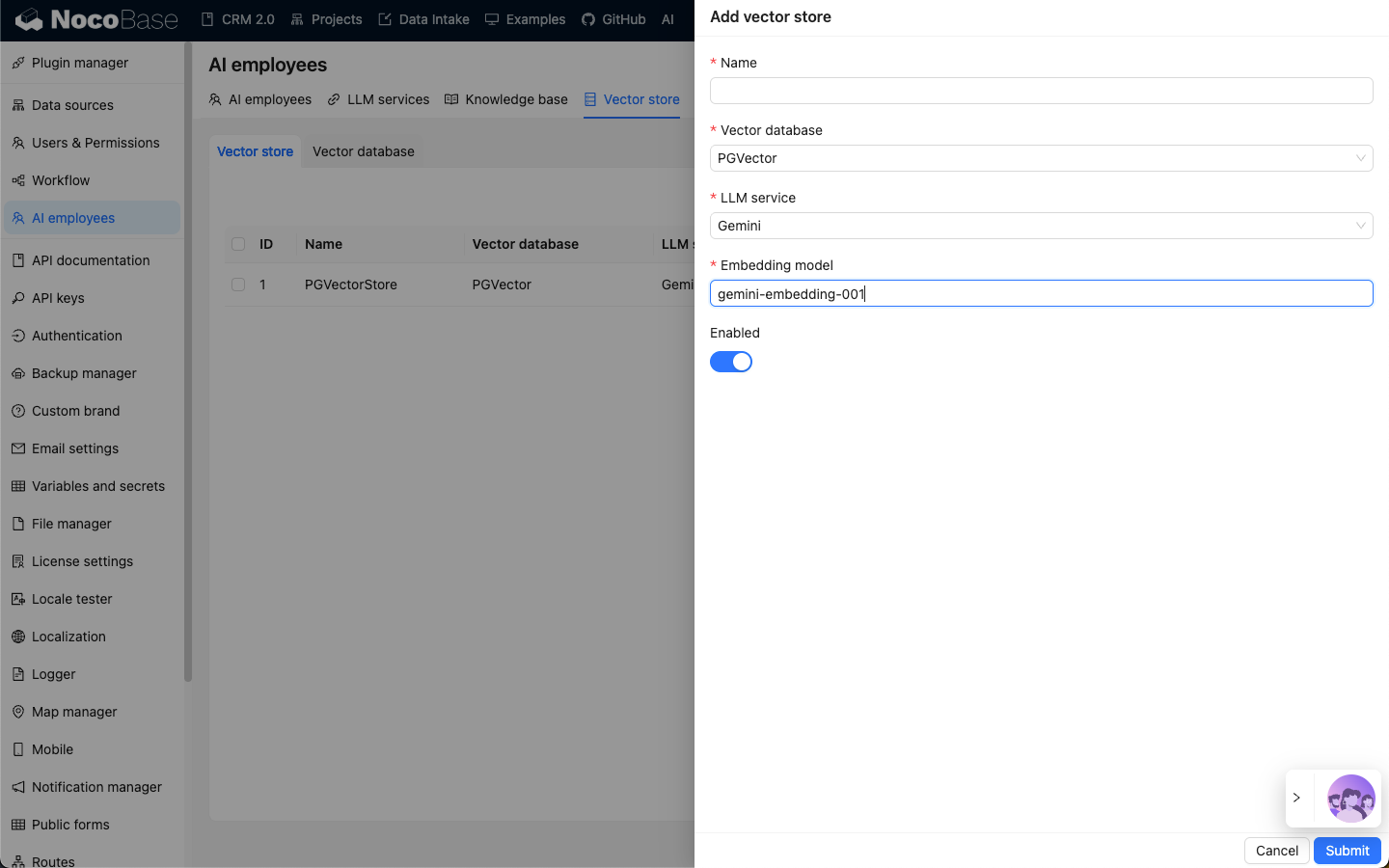

Klicka på knappen Add new uppe till höger för att lägga till en ny vektorlagring:

- I inmatningsfältet

Nameanger ni namnet på vektorlagringen; - Under

Vector storeväljer ni en redan konfigurerad vektordatabas. Se: Vektordatabas; - Under

LLM serviceväljer ni en redan konfigurerad LLM-tjänst. Se: Hantering av LLM-tjänster; - I inmatningsfältet

Embedding modelanger ni namnet på denEmbedding-modell som ska användas;

Klicka på knappen Submit för att spara informationen om vektorlagringen.